Un projet de loi de « lutte contre les fraudes sociales et fiscales » est débattu en ce moment à l’Assemblée nationale, après une première lecture au Sénat. Ce texte prévoit d’augmenter les pouvoirs d’enquête pour le contrôle des prestations sociales, en élargissant notamment l’accès aux fichiers des administrations et organismes privés. Il illustre les dérives des politiques de « lutte contre la fraude sociale » qui, en 20 ans, ont démultiplié les capacités de contrôle et de surveillance des administrations sociales. Revenons sur le contexte général de l’accès aux données des administrations avant d’expliquer en quoi ce projet de loi est un danger.

Au cours des années 2000, le récit d’un système social dont la pérennité serait « menacée » par la « fraude sociale » s’est imposé. Si ce discours s’est construit en dépit de toute réalité statistique – l’ensemble des estimations disponibles démontrent que la « fraude sociale » est marginale et bien plus faible que la fraude fiscale –, ses conséquences sont bien réelles. Loi après loi, la figure de « l’assisté·e » profitant indûment de la solidarité nationale a permis de justifier le renforcement drastique des politiques de contrôle, dont une large partie repose sur l’extension continue des accès aux données personnelles de la population.

Vingt ans plus tard, le bilan est accablant. L’ampleur des informations auxquelles peuvent avoir accès les contrôleurs·ses des principales administrations sociales – CNAF, CNAM, CNAV, France Travail – afin de vérifier l’exactitude des déclarations (revenus, situations professionnelle et familiale, résidence sur le territoire) est immense et leur nature profondément intrusive.

Le contrôle est facilité par la finalisation, dans les années 2010, d’immenses projets de centralisation des données personnelles de la population française et le pouvoir d’accéder, sur demande, aux informations détenues par des tiers aussi variés que les administrations, les entreprises ou les services de police.

Centralisation des données et contrôle social

Parmi les principaux projets de centralisation, notons notamment le developpement du « Répertoire de Gestion des Carrières Unique » (RGCU) utilisé par l’assurance vieillesse pour le calcul des retraites. Il offre un historique des périodes de travail salarié et couvre les dates de début et de fin de contrat ainsi que les salaires perçus.

Côté prestations sociales, une vue d’ensemble est offerte par le « Répertoire National Commun de la Protection Sociale » (RNCPS). Retraites, assurance maladie, chômage, prestations familiales, minima sociaux: ce fichier, qui agrège les données détenues par plus de « 60 institutions nationales, 90 organismes ou fonds nationaux et 1 000 organismes gestionnaires », permet de consulter les droits sociaux (nature, montants, dates) dont bénéficie chaque individu.

Le tout est complété par le transfert des données fiscales – notamment les déclarations de revenus – qui fournissent, à un rythme annuel, les revenus financiers ainsi que des accès aux bases recensant les données patrimoniales (biens immobiliers, assurances-vie, etc.). L’administration fiscale offre par ailleurs un large accès au fichier des comptes bancaires ouverts en France (FICOBA) qui, associé au droit de communication discuté ci-après, permet un accès aux relevés bancaires.

Ces fichiers reposent notamment sur deux gigantesques projets de centralisation des données de revenus de la population finalisés dans les années 2010 : la « Déclaration Sociale Nominative » (DSN) pour les salaires et le « Prélèvement à la Source – Revenus Autres » (PASRAU) pour les revenus versées par les organismes de protection sociale (assurance vieillesse, maladie, chômage, CAF…). Mises à jour mensuellement, ces bases offrent une vision quasi exhaustive et actualisée en temps réel des revenus de la population.

La vérification de l’état civil – nom, prénom, date et lieu de naissance ou de décès – est assurée par le Système National de Gestion des Identifiants (SNGI) qui centralise les flux provenant de l’ensemble des mairies de France. Ce fichier joue par ailleurs un rôle majeur dans l’infrastucture numérique de contrôle en associant aux données d’état civil un identifiant unique, le NIR ou numéro de sécurité sociale, pilier de l’interconnexion généralisée des fichiers administratifs. Pour les personnes étrangères, cette vérification s’accompagne d’un contrôle de la validité des titres de séjour via la consultation du fichier des titres de séjour du ministère de l’Intérieur (AGDREF).

L’accès à ces données est facilité par le déploiement de portail comme EOPSS (Espace des Organismes Partenaires de la Protection Sociale) qui permet la consultation à de multitudes bases de données comme le SNGI, le RNCPS ou les données de carrière.

Déployés entre autres pour permettre l’accès aux droits, ces fichiers sont également utilisés pour des finalités de lutte contre la fraude. Et, lorsqu’une administration n’a pas accès, directement ou indirectement, à ces fichiers, le droit de communication vient à la rescousse.

Un droit de communication exorbitant

Le droit de communication permet aux contrôleurs·ses d’obtenir les documents et renseignements de leur choix directement auprès d’un très grand nombre d’acteurs publics et privés, sur demande et pour une personne donnée. De par son étendue, ce droit représente, pour reprendre les termes du commentaire autorisé d’une décision du Conseil Constitutionnel sur le sujet, « un véritable pouvoir de réquisition » proche de celui dont disposent les forces de police.

Il permet aux contrôleurs·ses de demander, sans que le secret professionnel ne puisse s’y opposer, des informations aux différentes administrations de l’État , aux collectivités territoriales (mairies, départements) et à l’ensemble des organismes sociaux (CAF, France Travail, caisses de retraites, assurance maladie…). En pratique, ceci revient à disposer d’un accès, sur simple envoi de mail, aux quantités phénoménales d’informations dont l’administration dispose sur chacun·e d’entre nous.

Concernant le secteur privé, c’est sur la base de ce droit que sont rendus possibles les accès aux relevés bancaires lors d’un contrôle. Mais les contrôleurs·ses peuvent aussi envoyer des demandes à des organismes aussi variés que les fournisseurs d’énergie, les plateformes de vente en ligne (Le Bon Coin, Airbnb), les employeur·ses, les bailleurs sociaux, les organismes de transport, les notaires ou encore les huissiers.

Enfin, les contrôleurs·ses peuvent obtenir des informations directement auprès des forces de police dans le cadre des « comité départementaux anti-fraude » (CODAF) dont nous dénoncions l’instrumentalisation par la police à des fins de répression sociale dans un article en septembre dernier.

Le projet de loi en discussion

Voilà pour un bilan rapide et non-exhaustif des pouvoirs conférés aux contrôleurs·ses des principaux organismes sociaux tels que la CNAF, CNAM, CNAV ou France Travail. Si cet état des lieux ne s’attache pas à présenter le détail des différences entre chacun de ces organismes, il permet néammoins de saisir l’étendue des données d’ores et déjà disponibles en cas de contrôle et de mettre ainsi en perspective la fuite en avant que représentent les mesures du projet de loi actuellement en discussion :

– L’article 2 prévoit une extension de l’accès direct aux bases de données patrimoniales de l’administration fiscale. Autorisé pour les agents de la CAF, de France Travail ou des Mutualités Sociales Agricoles, cet article vise à l’étendre à l’Assurance Maladie, à la CNAV et aux agents des départements et des maisons départementales des personnes handicapées (MDPH).

– L’article 2 bis prévoit l’autorisation de consultation du RNCPS pour les services préfectoraux à des fins de contrôle des titres de séjour.

– L’article 6 autorise les MDPH et les services chargés de l’allocation personnalisée d’autonomie – une aide pour les personnes âgées en difficulté – à échanger toutes informations à des fins de lutte contre la fraude avec un large nombre d’acteurs (administrations sociales, police, douane, fisc…) dans le cadre notamment des « Comités opérationnels départementaux anti-fraude » (CODAF).

– L’article 10 vise à étendre le droit de communication, jusqu’ici réservé aux agents de contrôle agréé·es et assermenté·es, aux directeurs des Caisses Primaires d’Assurance Maladie (CPAM) et des CAF et au personnel placé sous leur responsabilité agissant en matière de lutte contre la fraude.

– L’article 28 vise à donner, selon l’exposé des motifs de l’amendement du Sénat l’ayant introduit, la possibilité aux agents de contrôle de France Travail d’accéder au fichier des passagers aériens – nom, prénom, date d’embarquement, destination – ainsi qu’aux relevés téléphoniques et aux données de connexion des inscrit·es.

« Des fichiers, il y en a quand même un paquet. Lequel vous ferait plaisir ? »

Commençons par analyser les mesures plus « techniques » avant de revenir à l’article 28. Si leur portée peut être difficile à saisir, elles incarnent néammoins des processus politiques centraux dans l’expansion des pouvoirs conférés aux organismes sociaux au titre de la « lutte contre la fraude sociale ».

À commencer par le fait qu’une large part de ces mesures sont prises par pur opportunisme politique, en dehors de tout examen de proportionnalité ou de nécessité. Leur annonce vise avant tout à mettre en scène le « volontarisme » de nos parlementaires face à un problème – la fraude sociale – qu’ils et elles ont largement contribué à construire et à amplifier comme nous le rappellions au début de cet article. Au nom d’une recherche « d’efficacité » devenue un objectif en soi, tout ce qui est réalisable techniquement devient envisageable politiquement, sans considération pour la proportionnalité entre la gravité supposée de la fraude ciblée et les atteintes portées aux droits fondamentaux.

Ce sont peut-être les propos de la sénatrice Nathalie Goulet qui résument le mieux la situation lorsqu’elle demande à des responsables de la CNAF, à l’occasion d’une mission d’enquête sur la fraude sociale : « Des fichiers, il y en a quand même un paquet. Lequel vous ferait plaisir ? ».

Ajoutons enfin que les mesures les plus problématiques ciblent avant tout des populations jouant le rôle habituel de boucs émissaires (personnes précaires, étrangères, racisées, condamnées…). Et ces mesures seront très certainement, comme c’est systématiquement le cas en matière de répression, progressivement étendues au reste de la population une fois cette banalisation amorcée.

Une illustration frappante des logiques à l’oeuvre

À titre d’exemple, tournons-nous vers l’article 10. Ce dernier prévoit d’élargir le droit de communication à des agent·es des CAF et des CPAM qui ne sont ni agréé·es ni assermenté·es. Alors que la limitation à des agent·es spécialement habilité·es visait à offrir des garanties fortes, que la CNIL avait rappelées en 2017, voici comment cet article a été justifié.

Acte 1 : dans le projet de loi, le gouvernement propose cette mesure pour les seul·es agent·es des CPAM, en invoquant la nécessité d’intensifier les contrôles sur les bénéficiaires de la complémentaire santé solidaire, soit les 7 millions de personnes les plus pauvres de France. Celles-ci sont pourtant déjà ciblées par un algorithme discriminatoire, alors même que la fraude estimée ne représente qu’environ 1% des montants versés. Acte 2 : le gouvernement banalise les atteintes à la vie privée que cette mesure représente en s’appuyant sur le précédent récent des agents de l’URSSAF, à qui un droit comparable a été accordé début 2025. Acte 3 : le Sénat propose l’extension de cette mesure aux agent·es de la CAF sans aucune justification ni motivation, par simple surenchère politique.

Une même inconséquence est à l’oeuvre concernant l’article 6 qui étend les échanges d’informations, dans les deux sens, entre les MDPH – en charge de l’attribution de l’Allocation d’Adulte Handicapé (AAH) –, les services en charge de l’APA – destinée aux personnes âgées en perte d’autonomie – et un nombre important d’institutions parmi lesquelles les forces de l’ordre, le fisc, les douanes, les organismes locaux de protection sociale, France Travail, l’Unédic, l’inspection du travail, les agences régionales de santé ou encore les services préfectoraux.

Cette mesure a été introduite par le gouvernement au seul motif qu’elle « pourrait entraîner des économies potentielles ». Sans plus d’information ni de justification, alors même que de tels échanges concernent des publics particulièrement vulnérables et des données médicales, qu’il est estimé que le taux de fraude aux aides à l’autonomie s’élève à seulement 1,46% de leur montant total, que les dossiers de la MDPH sont déjà examinés « en amont » et réévalués régulièrement via certificat médical et commission. Pour couronner le tout, le Sénat bascule dans le cynisme le plus total en justifiant la violation de la vie privée des personnes handicapées et de nos aîné·es en difficulté au titre que les « agissements frauduleux ne sont peut-être jamais aussi condamnables que lorsqu’ils sont faits à l’encontre des services publics destinés aux publics dont la situation est la plus vulnérable ».

Enfin, les articles 2 et 10 sont présentés comme une simple « harmonisation » d’une loi de 2018 sur la fraude, qui avait déjà autorisé l’accès aux bases patrimoniales pour certains organismes sociaux et donné aux forces de police un accès au RNCPS.

Article 28 : une fuite en avant

Venons-en, enfin, à l’article 28 du projet de loi, qui contient les mesures les plus controversées. Introduit par le Sénat, il vise à donner trois nouvelles prérogatives au service fraude de France Travail : l’accès au fichier des passagers aériens ou PNR (pour Passenger name record), l’obtention auprès des opérateurs des relevés téléphoniques des assuré·es et le traitement des données de connexion dont dispose France Travail.

Quels que soient leurs devenirs à l’Assemblée nationale ou au Conseil constitutionnel, ces propositions sont très inquiétantes. Elles traduisent la fuite en avant des parlementaires dès lors qu’il s’agit de communiquer sur le renforcement des moyens de surveillance à des fins de lutte contre la fraude sociale.

L’utilisation de fichiers comme le PNR, utilisé à des fins de lutte contre le terrorisme et la criminalité grave, par les administrations sociales symbolise l’absence de limites de nos parlementaires, à la seule fin de mise en scène de leur action politique. Surtout, il s’agit d’un détournement assez flagrant de ce fichier. Présenté comme limité aux seules fins de lutte contre le terrorisme pour justifier l’intrusion grave dans la vie privée des personnes qu’il opère, il se retrouverait détourné si cet article était voté.

Cette extension des usages du fichier PNR n’est pas une première : à chaque fois qu’un fichier est disponible, nous savons que l’État voudra se servir des données collectées, peu importe le respect des droits fondamentaux. Récemment, nous avons par exemple mis au jour le détournement du fichier TES à des fins d’identification des personnes dans le cadre d’enquêtes de police alors que ce fichier n’était pas censé permettre cela. Encore avant, c’était le projet de loi « Simplification » qui servait là encore au détournement de finalités, cette fois-ci pour détourner à des fins de contrôle les données collectées pour calculer les aides sociales. Ces exemples pourraient être multipliés.

Protection sociale contre contrôle social

Nous suivrons avec attention les discussions autour de ce texte à l’Assemblée nationale, tout particulièrement vis-à-vis de l’article 28. Si ces dispositions sont maintenues, nous appelons chacun·e à se mobiliser pour empêcher leur vote.

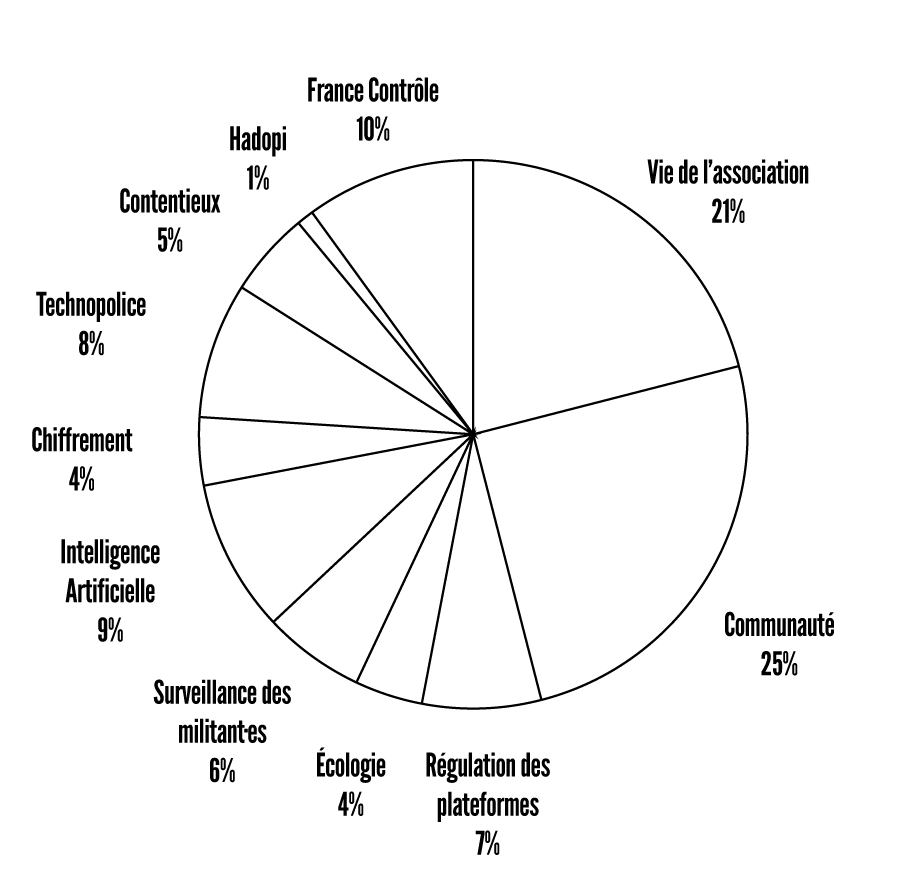

Surtout, nous continuerons de lutter, au sein de notre campagne « France Contrôle », contre l’extension des mesures de surveillance via notre système de protection sociale. La multiplication des mesures intrusives et l’accroissement du contrôle social au nom de la « lutte contre la fraude » doivent cesser.

Vecteurs de violences, d’humiliation et de précarité, ils constituent le bras policier des attaques sur notre système social. Le discours politique venant les justifier, empreint de mépris et de domination sociale, doit être dénoncé. Ce combat, qui promet d’être long, est possible grâce à votre soutien. Nous espérons pouvoir le continuer pour les années à venir, alors, si vous le pouvez, n’hésitez pas à nous faire un don.